Manipuliranje informacijama drevna je praksa. Nekada se to radilo pomoću govorničkih vještina i pisane riječi. Razvojem medija, posebno onih digitalnih, ta ista praksa je poprimila i neke druge oblike. Deepfake i slične tehnologije bi sve to skupa mogle podignuti na jedan novi nivo.

Od fake news-a do deepfake-a

S obzirom na samu dostupnost i na moć koju mediji danas imaju na ljude, ne trebaju nas čuditi pokušaji manipuliranja informacijama. Od senzacionalističkih naslova (engl. clickbait), preko maliciozno “fotošopiranih” fotografija, do lažnih vijesti (engl. fake news). U zadnje vrijeme, sve je popularniji i spomenuti alat zvani deepfake, koji spada u umjetnu inteligenciju.

Šta je deepfake?

Sama riječ deepfake je složenica pojmova deep learning (“duboko učenje”) i fake (“lažno”, ono što nije originalno, nije autentično). Duboko učenje je grana mašinskog ili strojnog učenja, a ono spada u oblast umjetne inteligencije.

Izraz deepfake se odnosi na krivotvoreni, digitalno stvoreni video, kojeg je teško (i sve teže) razlikovati od originala. Ono što su Photoshop i slični programi za slike, to je deepfake za video. Ovaj alat postaje sve dostupniji i sve sofisticiraniji.

Kako deepfake funkcionira?

Deepfake se bazira na nečemu što zovemo generative adversarial networks (GANs), odnosno “generativne suparničke mreže”. To je tehnologija koju je izumio Ian Goodfellow 2014. godine, u to vrijeme student, a danas zaposlenik Apple-a.

Algoritam GAN uključuje dvije odvojene umjetne inteligencije (Artificial Intelligence – AI), jednu koja generira sadržaj – na primjer, fotografije lica ljudi – i drugu, “protivničku”, koja pokušava prepoznati da li su te fotografije stvarne ili su lažne, tj. radi li se o pravim licima ili ne.

Prvi AI, onaj koji proizvodi sadržaj, na početku gotovo da nema pojma kako ljudska lica izgledaju. To znači da njegov partner može lako razlikovati lažne od pravih fotografija. Međutim, vremenom, oba AI-ja postaju sve bolja (uče), tako da prvi AI (zvani Generator) počinje generirati lica ljudi koja izgledaju tako uvjerljivo, da ovaj drugi (Diskriminator) sve teže može razlikovati ona prava od lažnih (kompjuterski generiranih) lica.

Neuronske mreže kao “umjetnici”

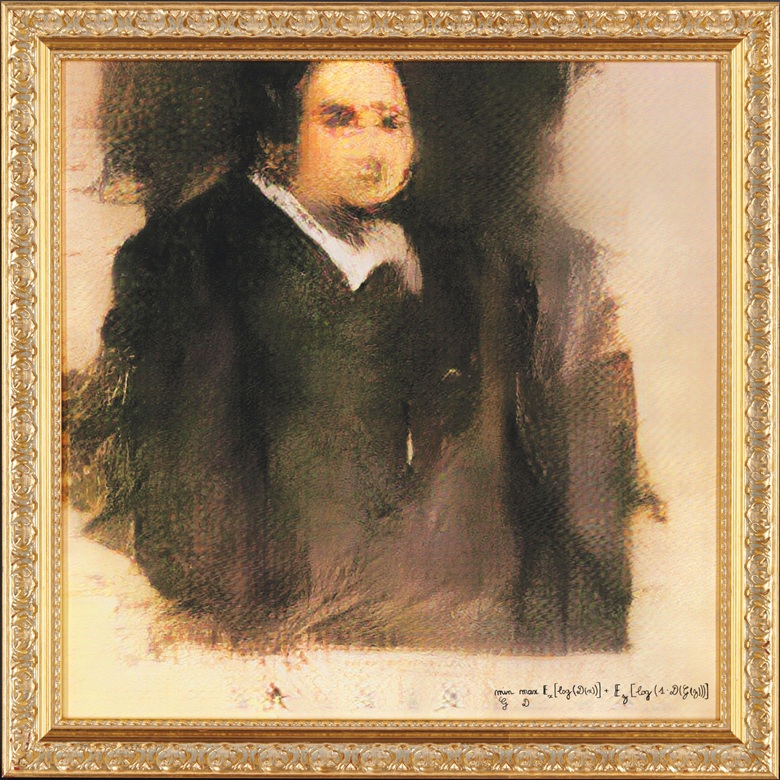

GAN-ovi su fascinantni alati i ne koriste se uvijek u neke loše svrhe. Na primjer, koristeći GAN-ove, kompjuter je 2018. godine “naslikao” Portret Edmonda de Belamyja, a pokušavajući slijediti tehniku starih majstora kao što je Rembrandt (1606. – 1669.). Ta slika je prodana na aukciji za čak 432 500 dolara (Christie’s, New York City). Portret Edmonda de Belamyja je prva slika na svijetu koju je napravila umjetna inteligencija, a da je ponuđena na aukciji.

Opasnost od korištenja deepfake-a u političke svrhe

S druge strane, istraživači sa Univerziteta u Washingtonu (Seattle), pokazali su koliko GAN-ovi mogu biti i opasni, upravo radi uvjerljivosti krajnjeg rezultata. Naime, oni su 2017. godine istrenirali algoritam da promijeni govor iz jednog video klipa bivšeg predsjednika SAD-a Baracka Obame, tako da se Obamine usne miču u skladu s riječima iz potpuno različitog govora.

Diskreditiranje pojedinačnih osoba

Također, iste godine je anonimni korisnik jedne društvene platforme počeo objavljivati deepfake porno filmove sa poznatim osobama. Naime, koristeći GAN tehnologiju, umetao je lica slavnih osoba – pored ostalih, Gal Gadot, Maisie Williams i Taylor Swift – na tijela porno glumica.

Dovoljna i jedna fotografija

Drugi GAN-ovi su naučili da od samo jedne fotografije osobe naprave realistične alternativne fotografije ili video te iste osobe. Na primjer, ove godine (2019.), ruski istraživači su napravili deepfake koji je bio u stanju generirati pomalo jezive, ali prilično uvjerljive snimke Mona Lise koja pomjera glavu, priča i smješka se.

Ipak, što ima više materijala na raspolaganju, tj. fotografija i videa, i sam deepfake će biti uvjerljiviji.

Deepfake može manipulirati i glasom

Pored same slike, odnosno videa, deepfake-ovi također mogu izmijeniti i audio sadržaj. Pomoću ove tehnologije je moguće umetnuti nove riječi u govor osobe koja u videu priča, tako da na kraju ispadne kako je rekla nešto što nije mislila reći. Dakle, relativno malim intervencijama se promijeni sadržaj poruke koju je osoba htjela poslati u javnost.

Deepfake: potencijalna opasnost u bliskoj budućnosti

Iako se razlika između originala i falsifikata još uvijek može raspoznati golim okom, već je sada jasno da deepfake može imati potencijalno zastrašujuće posljedice, posebno u bliskoj budućnosti. Bilo da se radi o utjecaju na mase (manipulacijom govora i izjava političkih i vjerskih vođa) ili o diskreditaciji pojedinačnih ljudi (javnih ličnosti ili privatnih osoba), ovako uvjerljive snimke lažnog sadržaja upozoravaju na oprez.

Naravno, to ne znači da trebamo izbjegavati deepfake ili bilo koju drugu tehnologiju, već da valja imati zdravu dozu opreza i kritičke svijesti kada konzumiramo medijski sadržaj.